Новый рубеж в борьбе с ботами: как российские учёные научились узнавать ИИ по ответам

В Самарском университете им. Королёва разработали методику распознавания интернет-ботов, которые маскируются под человека и обходят традиционные проверки.

Что делает ИИ «нечеловечным»?

В эпоху, когда каждый третий комментарий в соцсети может быть написан не человеком, а алгоритмом, а новости в телеграм-каналах генерируются чат-ботами на базе больших языковых моделей (БЯМ), вопрос - «кто пишет?» стал вопросом адекватности и безопасности информационной среды. И вот российские учёные из Самарского университета им. Королёва предложили прорывной способ, как отличить ИИ от человека. Не по скорости ответа, не по стилю текста, а по «возрасту» информации.

Представьте: вы задаёте ИИ-ассистенту простой вопрос: «Какова численность населения Санкт-Петербурга на 1 января 2025 года?». Человек, если не знает точно, скажет: «Не уверен, но, кажется, около 5,5 млн». Или уточнит: «Проверю и отвечу». А ИИ? Часто он выдаёт список ссылок. «Согласно данным Росстата, опубликованным в 2023 году…», «См. также: сайт городской администрации, раздел статистика…».

Это не ошибка. Это особенность. Большие языковые модели обучаются на данных, зафиксированных на определённую дату - скажем, 2023 год. Они не обновляются в реальном времени. И когда сталкиваются с вопросом, выходящим за рамки их «знания», они не «думают», они копируют. Возвращают фрагменты из своих обучающих корпусов - с источниками, как будто это научная статья, а не диалог с человеком.

Самарские исследователи заметили: это уникальный «指纹» (отпечаток) ИИ. Не поведение, не частота постов, не грамматические ошибки, а структура ответа на свежий вопрос. Человек говорит «не знаю». ИИ говорит: «вот ссылки». И это ключ к распознаванию.

Почему это важно и почему раньше этого не замечали

До сих пор борьба с ботами строилась на анализе активности: частота постов, время ответа, шаблонность текста. Методы, разработанные в США и Европе (например, BotArtist 2023 года), использовали машинное обучение для выявления «ботовых» аккаунтов, но они не различали человека и ИИ-агента. А ведь теперь это разные угрозы.

Человек может быть агрессивным, несбалансированным, но он знает, что происходит сейчас. ИИ может быть вежливым, грамотным, даже умным, но он заперт в прошлом. И именно эта «старость» - его слабость. Самарский метод превращает её в оружие.

Это как отличить актёра от настоящего человека: актёр может говорить идеально, но не знает, что случилось за кадром. ИИ тоже актёр. Только теперь у нас есть «камера», которая видит, что он читает по сценарию, а не пользуется живым опытом.

От лаборатории — к соцсетям: как это будет внедряться?

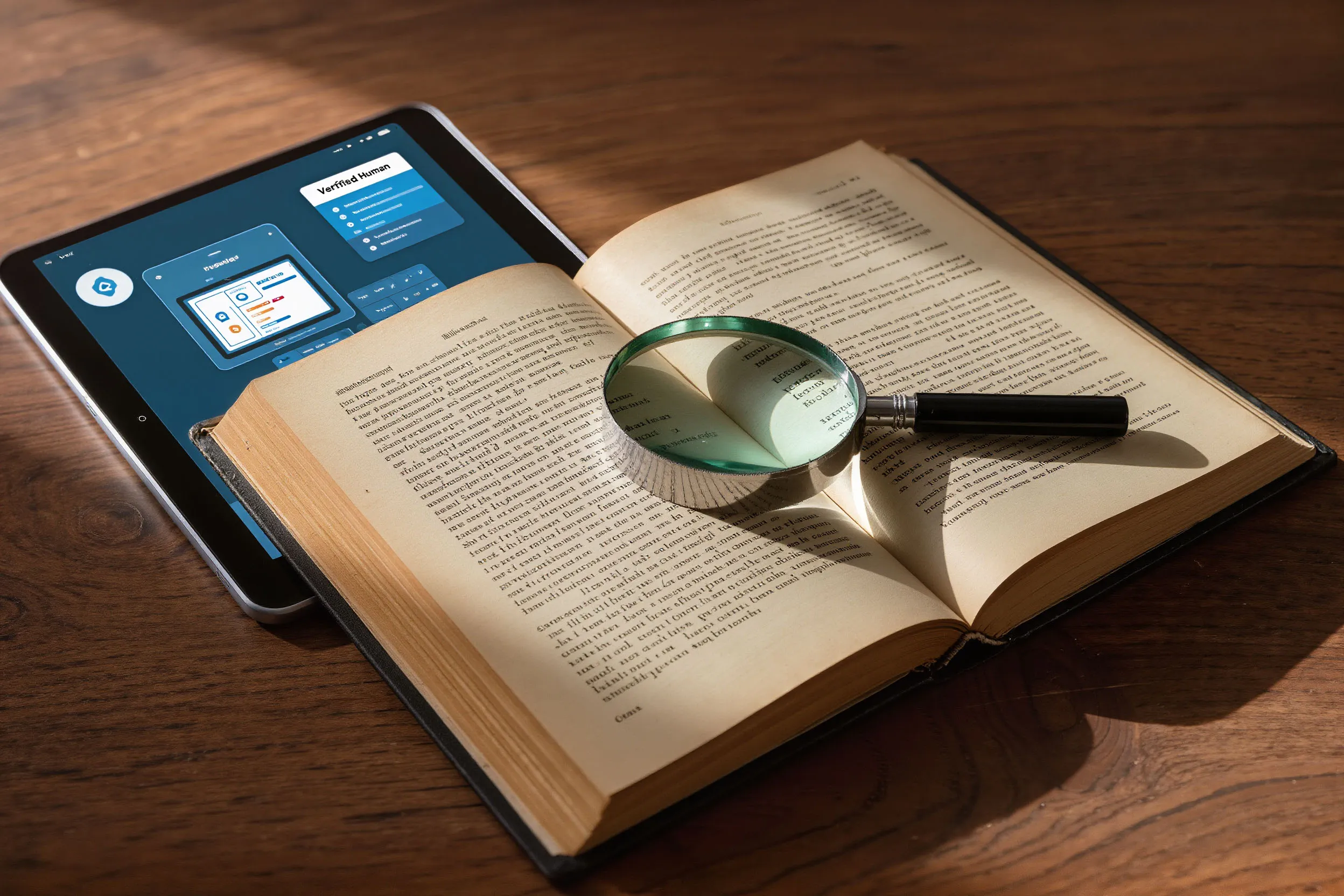

Метод пока что экспериментальный. Публикация вышла в российском журнале «Искусственный интеллект и принятие решений». Но уже сейчас его можно адаптировать под реальные условия. Представьте: платформа, где пользователи обсуждают выборы, референдумы, политические скандалы. Система модерации внедряет «контрольный вопрос» в фоновом режиме. Например: «Сколько вакансий было создано в России в октябре 2024 года?» Ответ с ссылками на устаревший отчёт Росстата - и вот он, бот. Ответ: «Не слышал, но вчера в новостях говорили, что рост был» — и это, скорее всего, человек.

Такой подход можно интегрировать в комментарии на сайтах СМИ, форумы образовательных платформ, системы проверки голосований в соцсетях, в чат-поддержку государственных сервисов. В краткосрочной перспективе (1–2 года) российские ИТ-компании и госструктуры получат мощный инструмент для борьбы с дезинформацией без нарушения приватности: вопрос задаётся системой, а не человеком. Никто не узнает, что его «тестируют».

Глобальный потенциал и вызовы

Зарубежные аналоги, как правило, фокусируются на поведении: сколько твитов в час, как часто меняются никнеймы. Самарский подход первый в мире, который смотрит на содержание ответа через призму обновляемости знаний. И это принципиально новый вектор.

Если метод доработать, превратить в API-модуль и предложить Google, Meta, Telegram, то он может стать стандартом. Особенно в странах, где борьба с фейками - приоритет. Даже в условиях санкций российская технология может экспортироваться как «умный фильтр» для цифровой безопасности.

Злоумышленники тоже начнут «обучать» ботов не только на старых данных, но и на предсказуемом ответе со ссылками, чтобы обойти проверку. Появятся «умные боты», имитирующие человеческие «не знаю» и «проверю». Тогда метод нужно будет обновлять как вирусную базу в антивирусе. Кроме того, возникает этический вопрос: если платформа «тестирует» каждого пользователя — не превращается ли это в цифровой патруль? Ответ: только в том случае, если тесты будут прозрачными, добровольными и не накапливающими личные данные. Здесь нужен законодательный каркас.

Будущее: кто победит — человек или ИИ?

Сейчас мы стоим на пороге новой эры: не просто борьбы с ботами, а с интеллектом, который не умеет быть несовершенным. Человек ошибается, забывает, сомневается - и именно это делает его человеком. ИИ стремится к точности, но теряет живость.

Самарская разработка — это не просто технический инструмент. Это философский сигнал: если ИИ не способен признать границы своих знаний, он не может быть доверенным собеседником. ИИ не «не знает», он не осознаёт, что не знает (и потому не может адекватно реагировать).

В ближайшие 3–5 лет мы увидим эволюцию: от простых «флагов» по ссылкам - к комплексным системам, которые анализируют стиль, паузы, логику, даже эмоциональную окраску. Возможно, в будущем ИИ-агенты будут сознательно избегать ссылок — и тогда их станут выявлять по другим признакам.

Российские учёные сделали важный шаг. Они не просто нашли дыру в ИИ. Они показали: настоящий интеллект - это не только знание, но и осознание его границ.

Метод из Самары не панацея, но первый в России и один из немногих в мире подход, который смотрит не на то, как говорит бот, а на то, что он не знает. Это шаг к цифровой грамотности, к защите демократических процессов и к тому, чтобы интернет оставался местом, где люди всё ещё могут доверять друг другу, а не алгоритмам.