Эксперт: «Безошибочного критерия для детектирования ИИ-текстов не существует»

Современные нейросети научились мастерски имитировать человеческий стиль, поэтому выявлять их участие становится всё сложнее

О том, легко ли отличить человеческий текст от машинного и как с этим справляются современные сервисы детекции, рассказал IT Russia кандидат физико-математических наук, эксперт в области академической этики, машинного обучения и ИИ, заведующий лабораторией №42 в ИПУ РАН и основатель сервиса интеллектуальной проверки академических работ Domate Юрий Чехович.

В основе сервиса Domate – многоэтапный анализ текста. Несколько десятков алгоритмических модулей с разных сторон анализируют извлечённую из файла с проверяемым документом информацию. На завершающем этапе результаты работы модулей объединятся в отчёт об оценке работы.

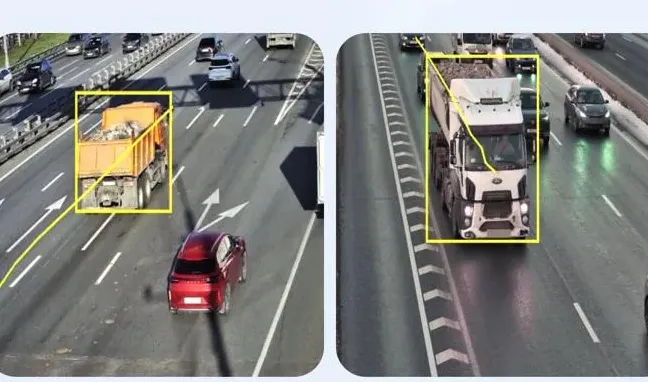

Он пояснил, что современные детекторы настроены на поиск таких маркеров, как: необычные слова, которые редко используются человеком; смещение частот частей речи (избыток глаголов или прилагательных) по сравнению с естественной речью; наличие синтаксических и стилистических перегибов, различия в порядке слов. А в академических и научных текстах алгоритмы ИИ часто выдают слишком длинные и перегруженные предложения.

Также важным маркером в академических текстах является список источников, на которые ссылаются авторы. Поскольку генеративный ИИ часто выдает фиктивные ссылки, то наличие их в библиографии как раз подтверждает факт использования машинной генерации.

Аналитика ценнее «вылавливания» присутствия ИИ-текста

По мнению эксперта, уже сейчас очевидно, что абсолютного и безошибочного критерия для детектирования не существует – алгоритмы детекции работают с вероятностями. Фактически детектор может лишь показать, что какой-то фрагмент текста похож на те, что обычно выдают генеративные модели. Кроме того, современные нейросети научились мастерски имитировать человеческий стиль, а генеративные технологии всё продолжают развиваться.