В России пиратский ИИ возьмут на абордаж

Новая технология позволяет подтверждать авторство ИИ-модели и предотвращать её использование без специального ключа

Российские учёные из научной лаборатории ИИ, анализа данных и моделирования имени профессора А. Н. Горбаня на базе Центрального университета разработали метод, который помогает защищать модели компьютерного зрения (нейросетей для интерпретации визуальных данных) от «пиратского» копирования и несанкционированного применения.

Главное отличие их подхода от подобных в том, что он не требует машинного переобучения: защитный механизм можно встроить прямо в уже готовую нейросеть. Разработка была представлена на конференции ICCV 2025 и получила высокие оценки экспертов.

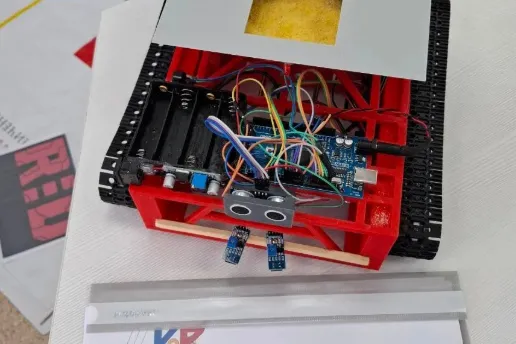

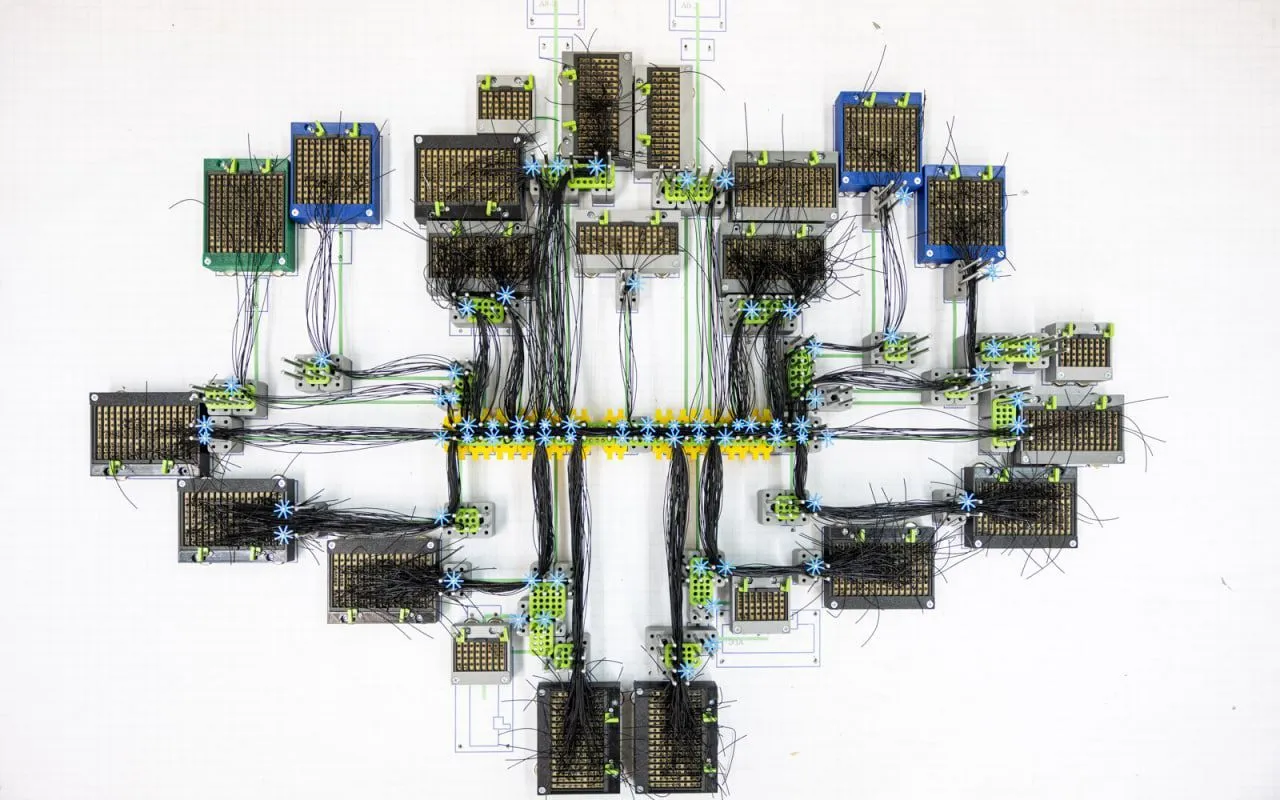

Нейрон-детектор

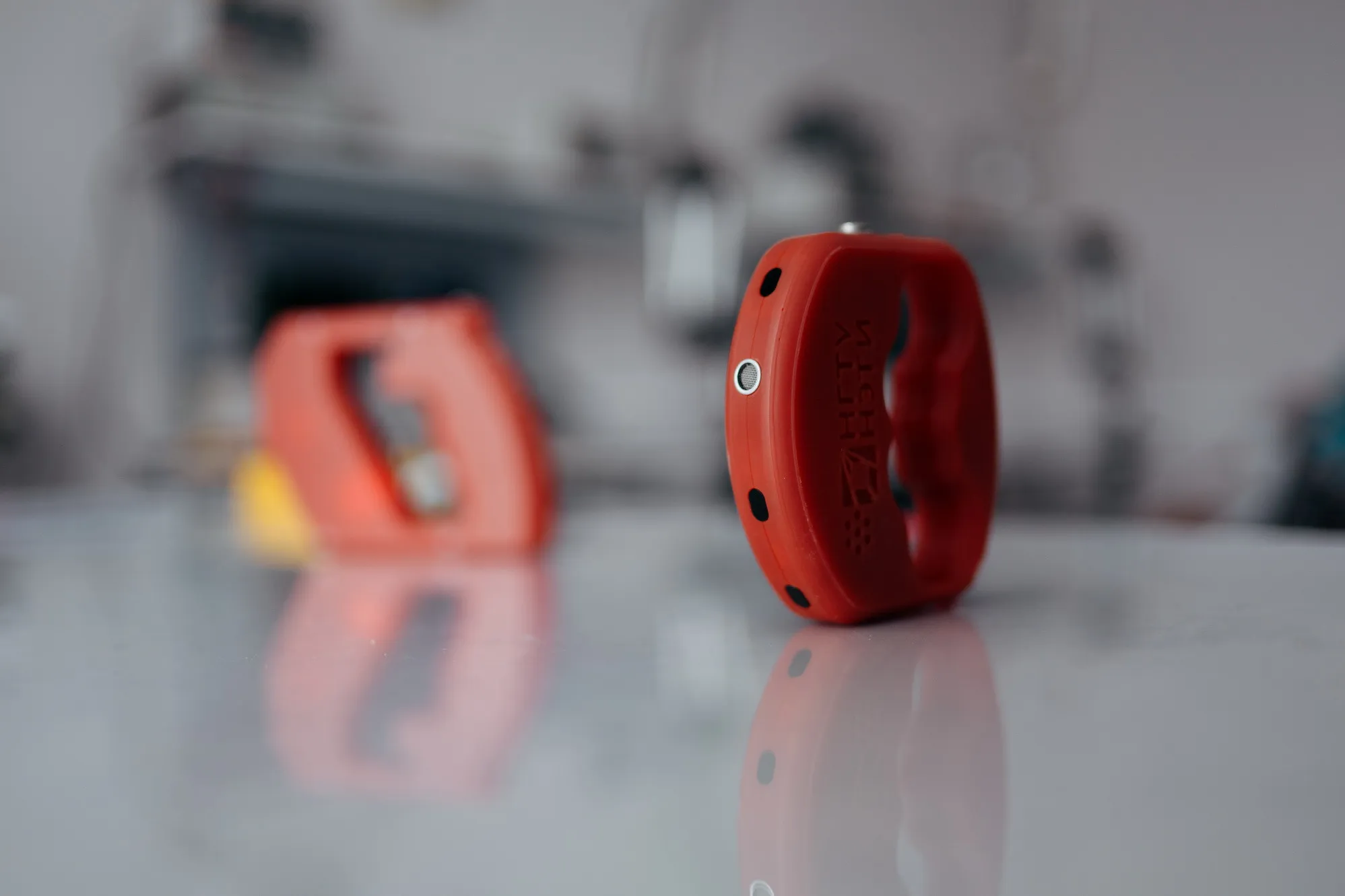

Основой метода стал специальный «нейрон-детектор», встроенный вместо одного из элементов обученной модели. Он остаётся незаметным при работе с обычными изображениями, но активируется при появлении секретного визуального ключа — небольшого узора, который можно встроить в картинку.

Активация позволяет идентифицировать модель и подтверждать права на неё и созданные ей изображения. Вероятность случайного срабатывания защиты минимальна, что делает метод пригодным для промышленного и коммерческого использования.

Механизм защиты

Технология также поддерживает режим защиты, при котором нейросеть корректно обрабатывает данные только при наличии того же ключа. Если защитный сигнал отсутствует, встроенные нейроны создают помехи, и модель перестаёт работать штатно. Это прямой аналог лицензионного механизма, встроенного в саму структуру нейросети, и делает ее незаконное применение бессмысленным.

Разработку можно интегрировать в любые модели компьютерного зрения без увеличения вычислительной нагрузки. Защитный механизм открывает возможности для безопасного внедрения ИИ в мобильных сервисах, медицине, финтехе и других областях, где особенно важны доверие и контроль над технологиями.