«Белый» и безопасный: российские ученые создали ИИ с прозрачной логикой

Россия сделала важный шаг на пути создания искусственного интеллекта (ИИ) с новой архитектурой. Его логика принятия решений остается всегда доступной для понимания человека. Таким образом российские ученые решают задачу соблюдения международных законов об ИИ.

Система на основе логических клеточных автоматов

Алгоритм, который делает искусственный интеллект максимально понятным для человека, разработали ученые из Института теоретической и экспериментальной биофизики РАН «ИТЭБ РАН» (Пущино) и Института биофизики клетки РАН.

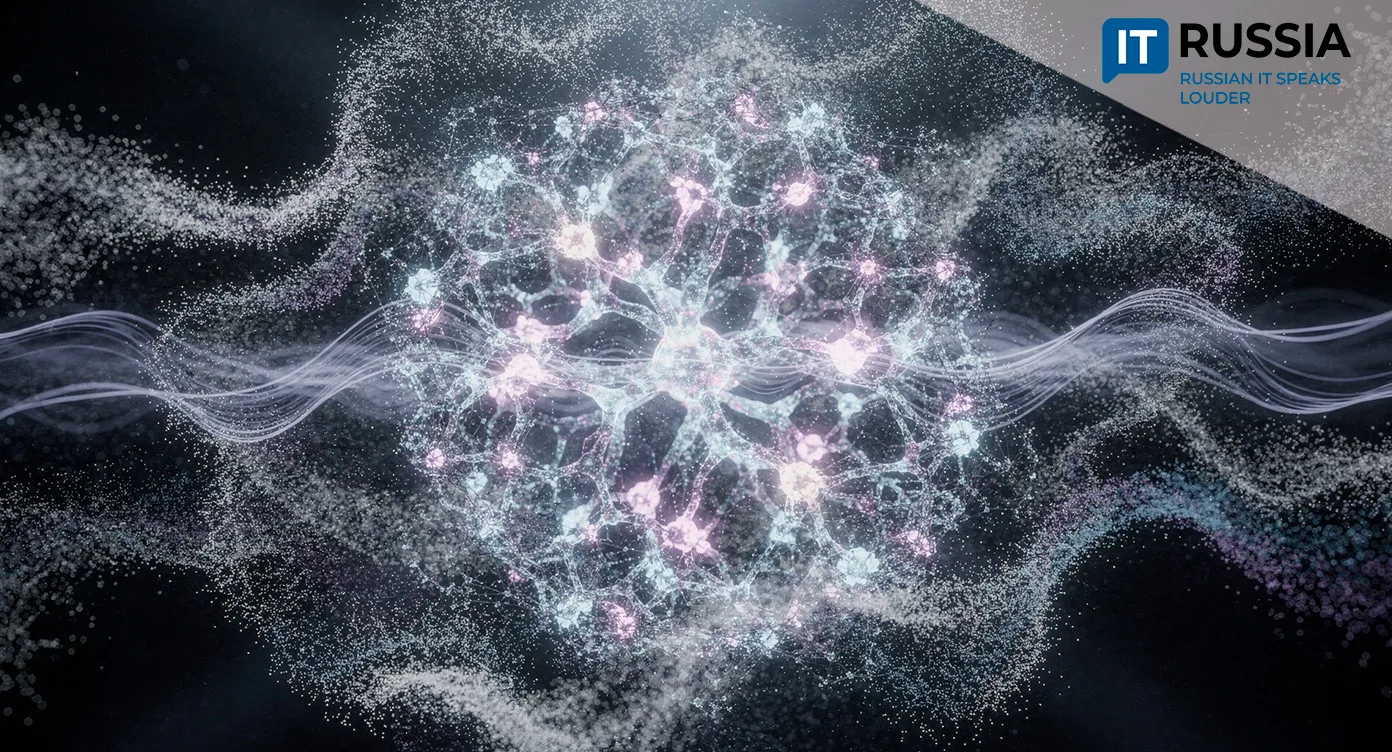

Новая система работает на основе логических клеточных автоматов, позволяя отслеживать каждый шаг принятия решений. Ее преимущество в том, что она представляет собой так называемый «белый ящик», в отличие от большинства современных систем, функционирующих по принципу «черного ящика». Это значит, что вся логика работы алгоритма доступна для анализа, а каждая стадия вычислений может быть отслежена. Этим она принципиально отличается от традиционных нейросетей.

Алгоритм создан российскими биофизиками и изначально использовался для автоматической проверки экологических гипотез, но сама работа заложила методологическую основу программы исследований и разработок по созданию символического ИИ общего назначения.

«Созданный логически прозрачный искусственный интеллект реализует автоматический логический вывод одновременно на трех уровнях организации сложной системы, учитывая локальные зависимости её микрообъектов. Онтологической основой прозрачного ИИ служит аксиоматическая теория соответствующей предметной области, а инструментальной основой являются логические клеточные автоматы», - отметил Лев Калмыков, научный сотрудник ИТЭБ РАН.

Тайны ИИ

Сегодняшние системы ИИ, основанные на машинном обучении и искусственных нейронных сетях, используют непонятные человеку алгоритмы принятия решений. В итоге люди видят входные данные и затем результат, но не понимают, как именно система пришла к сделанному выводу. Это создает риски ошибок и неконтролируемого поведения, а доработка алгоритмов становится сложной.

Проблема интерпретируемости ИИ настолько острая, что в 2016 году в США запустили программу XAI (Explainable AI), направленную на объяснение работы нейросетей. Однако это не устранило главный недостаток — невозможность полностью предсказать решения ИИ.

Результаты программы “XAI” помогли частично интерпретировать работу «черного ящика» нейронных сетей, но не изменили их первоначальную непрозрачную статистическую природу и неопределенность в отношении безопасности и надежности принимаемых решений.

Предложенный в России символический ИИ на основе логических клеточных автоматов полностью преодолевает проблему «черного ящика» ИИ, что отражено в названии предлагаемого подхода – «eXplicitly eXplainable Artificial Intelligence (XXAI)».

Доверие людей и выполнение правовых норм

Прозрачный ИИ решает множество проблем. Он укрепляет доверие людей к нейросетям, так как они понимают, как принимаются решения с использованием ИИ.

В свою очередь понимание процесса принятия решений с использованием ИИ даёт представление о том, не заложена ли предвзятая информация в алгоритмы и данные, которые нейросеть использует в качестве источников.

Кроме того, прозрачность позволяет понять источник сбоя или проблемы, приведшей к появлению нежелательного результата. Наконец, если использующая нейросеть организация знает, как работает система ИИ, она может улучшать и дорабатывать модели для повышения их производительности. Более того, прозрачность логики ИИ дает информацию для принципиальных решений о применения ИИ в конкретных ситуациях.

Наконец, созданный российскими учеными алгоритм помогает выполнять международные законы, например, закон ЕС об искусственном интеллекте, принятый Европейским парламентом 13 марта 2024 года и одобренный Советом ЕС 21 мая 2024 года. Там четко сказано, что системы с высоким риском, (в том числе оказывающие влияние на возможность людей получать средства к существованию, связанные с биометрическими данными или объектами критической инфраструктуры), должны быть подвергнуты усиленному регулированию и контролю со стороны человека.

А контроль без понимания логики работы ИИ невозможен. В перспективе в России предполагается разработка и гибридных систем, в которых прозрачные ядра сочетаются с «черными» алгоритмами. Это позволит сочетать объяснимость и мощность ИИ.

Таким образом, созданный в России алгоритм будет востребован не только на родине, но и за рубежом. Понятный в работе ИИ будет востребован в критических индустриях всех стран, потому что решает главную проблему – безопасность для человека.