Россиян учат распознавать искусственный контент

Эксперты дали советы по выявлению дипфейков

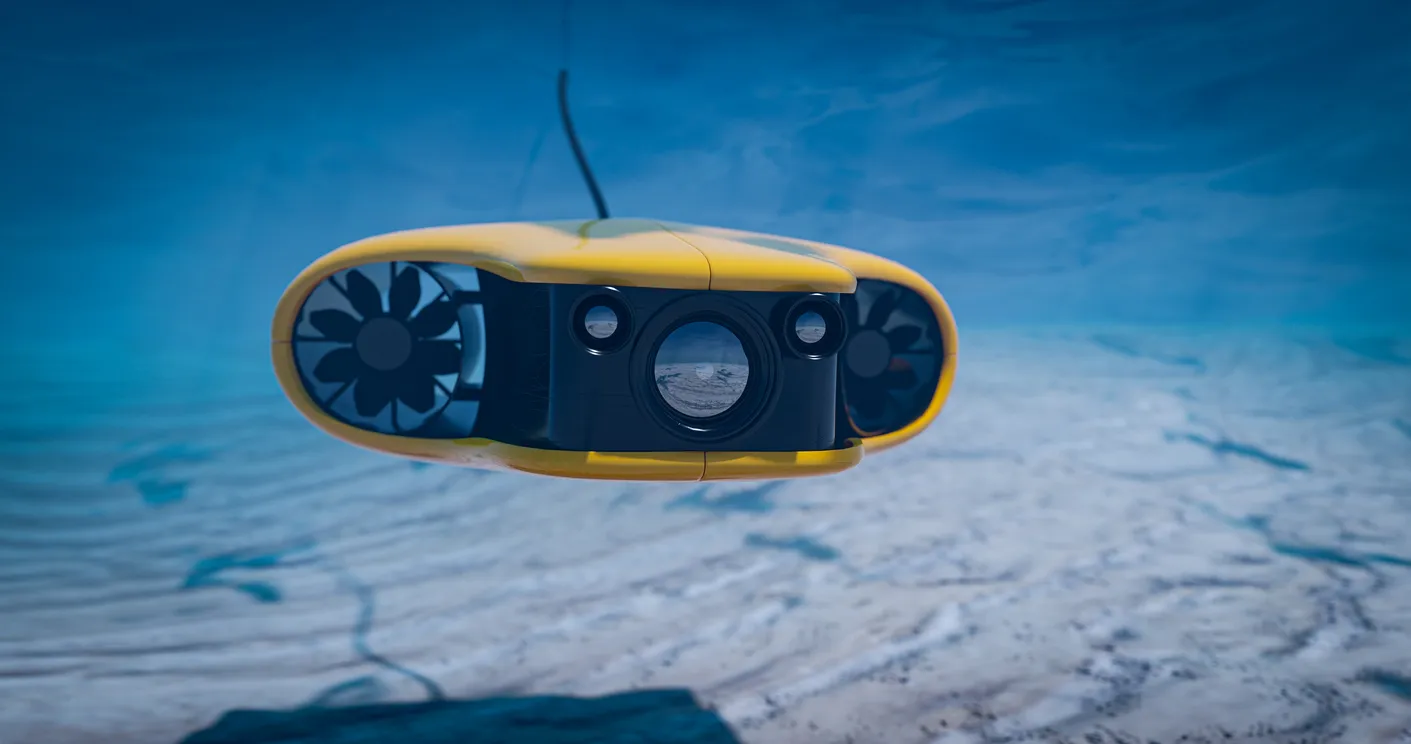

С развитием нейросетей отличить реальный контент от сгенерированного становится всё сложнее. Сегодня дипфейки стали оружием мошенников. Подделать голос или даже видеосообщение, чтобы ввести в заблуждение жертву, — распространённая схема обмана. Очевидно, что цифровая гигиена должна включать умение распознавать цифровых двойников и искусственно сгенерированные звуки и изображения.

Эксперты ВТБ назвали самые частые признаки изображений, созданных ИИ: они нередко содержат анатомические ошибки, искажения перспективы и нелогичные детали. Тексты часто выдаёт шаблонность. Чтобы не попасться на обман, обращайте внимание на детали: у людей на фото должно быть как минимум правильное количество пальцев, естественные тени, отсутствие странных надписей на непонятных языках или нелогичного порядка букв.

Всегда анализируйте то, что читаете. ИИ часто пишет расплывчато, чересчур оптимистично или с избыточными пояснениями. Самое опасное — он легко искажает факты и не умеет их проверять. Современные российские сервисы, такие как Forensic или GPTZero, также помогают выявлять искусственный контент.

«Главное — критически оценивать информацию и не доверять всему, что выглядит идеально», — советует Алексей Пустынников, эксперт ВТБ.