Российские учёные шагнули вперёд в области безопасного ИИ: новый метод повышает доверие к прогнозам нейросетей

Искусственный интеллект стал неотъемлемой частью жизни — от медицинской диагностики до промышленного контроля. С ростом масштабов внедрения ИИ всё острее встаёт вопрос: насколько можно доверять его решениям? Эту задачу взялись решить российские учёные из Центра искусственного интеллекта Сколтеха и Института проблем передачи информации им. А.А. Харкевича РАН (ИППИ РАН).

Почему важна оценка уверенности?

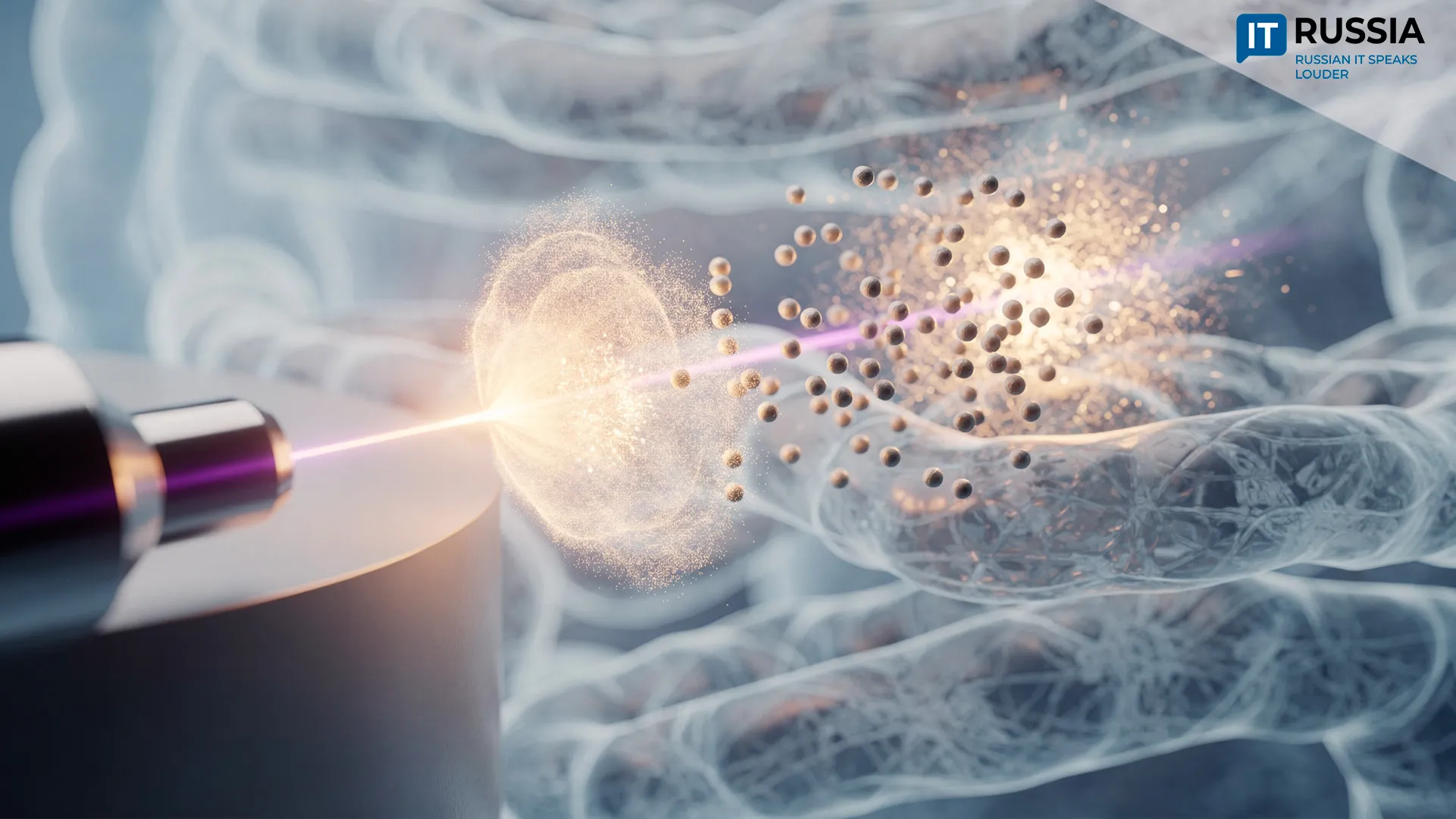

Новый метод, получивший название Confidence Aware Training Data, позволяет нейросетям адекватно оценивать уровень доверия к собственным прогнозам. Исследование уже прошло экспериментальную проверку на медицинских данных — в частности, в задаче типирования крови, что делает его особенно значимым для сферы здравоохранения.

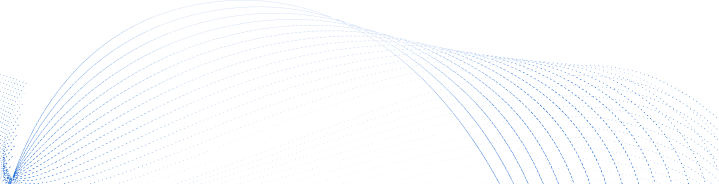

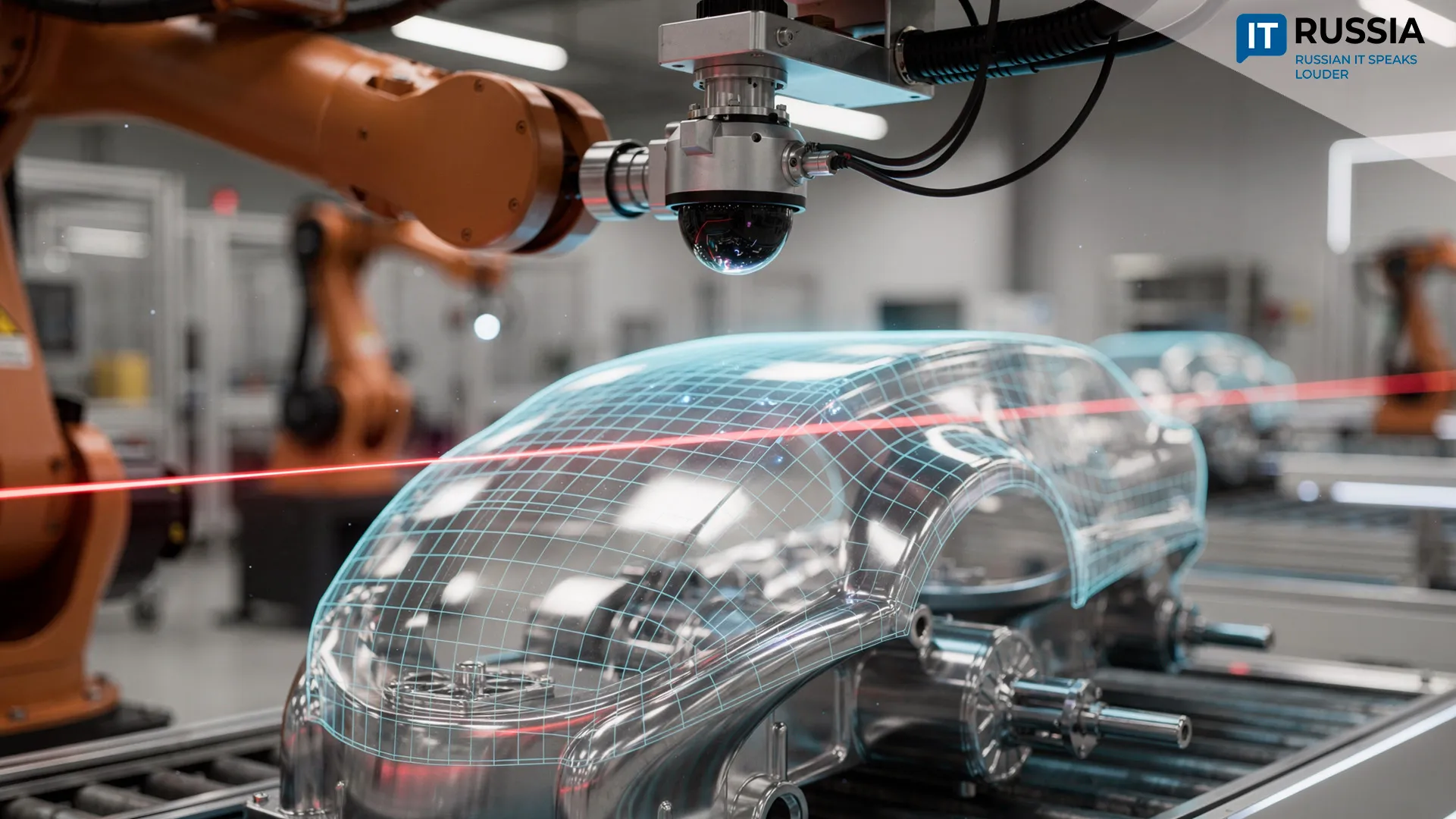

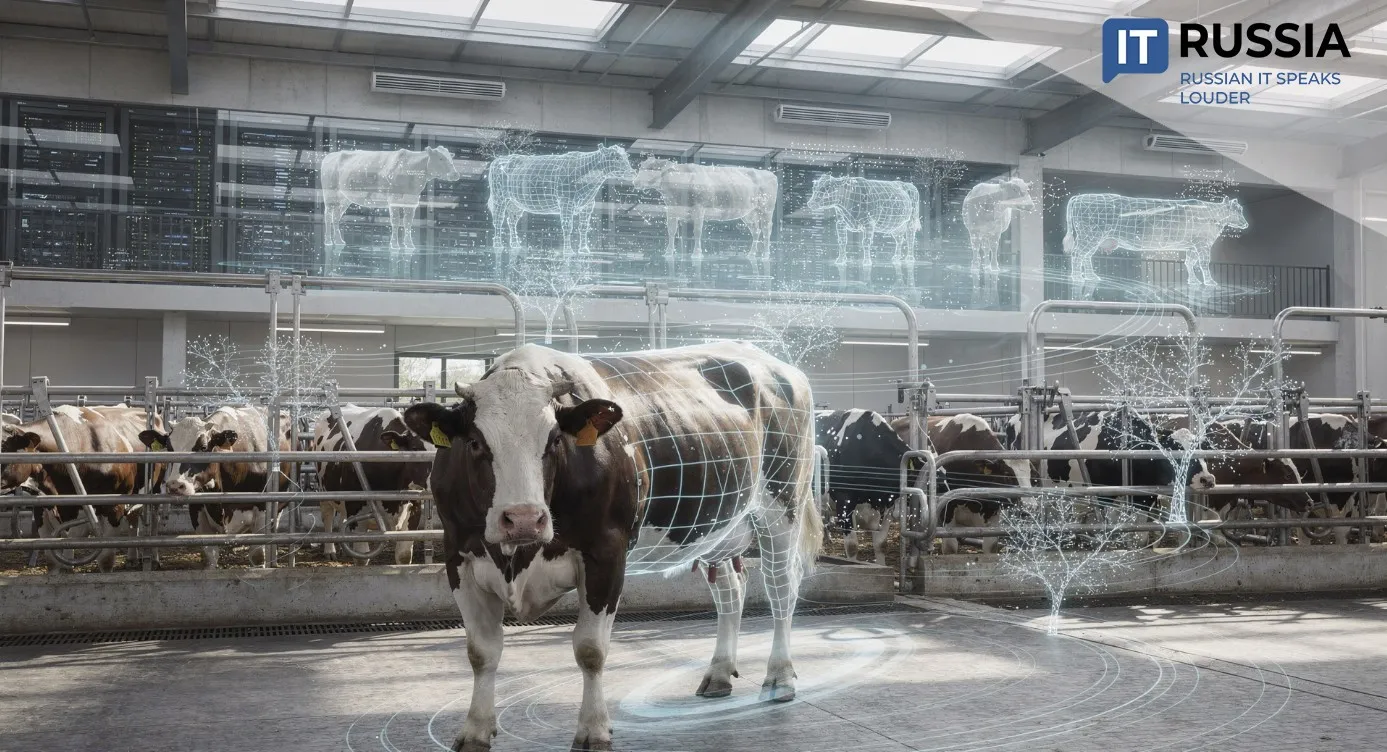

Одна из ключевых проблем современных нейросетевых моделей — их склонность к чрезмерной уверенности или, наоборот, к необоснованному сомнению. Особенно критично это в медицине, где ошибка ИИ может стоить человеческой жизни, или в промышленности, где неточность может привести к аварии. Новый метод позволяет системам не просто выдавать прогноз, но и указывать, насколько он надёжен. Это открывает путь к более ответственному использованию ИИ в критически важных областях.

Значимость открытия

С научной точки зрения, метод Confidence Aware Training Data – шаг к созданию так называемого «безопасного ИИ», способного к математической корректировке вероятностей и саморегуляции. Для российской IT-отрасли это означает укрепление позиций в направлении ответственного и надёжного применения искусственного интеллекта. В условиях ужесточения международных требований к безопасности и этике ИИ, такие разработки становятся конкурентным преимуществом.

Для общества же технология сулит снижение рисков, связанных с ошибками ИИ-систем. В медицине это приведёт к точной диагностике, а значит - к более эффективному лечению. В промышленности - к повышению уровня автоматизации без ущерба для безопасности.

На глобальном уровне российский метод способствует формированию международных стандартов безопасности ИИ-решений. Он подчёркивает важность разработки и внедрения технологий, которые не просто работают, но и умеют «понимать», насколько можно доверять их выводам.

Перспективы внедрения и экспортный потенциал

У технологии уже просматривается экспортная перспектива. Россия может предложить международному рынку медицинские и промышленные ИИ-системы с повышенной уверенностью в результатах. Такие решения могут быть востребованы в странах, где требования к безопасности особенно высоки - от Европы до Азии.

Внутри страны метод может быть внедрён в тестовые прототипы российских медтех-компаний и промышленных предприятий. Также возможна его интеграция в отечественные платформы, такие как Яндекс-Практикум и государственные реестры медицинских программ. Это усилит позиции России как страны, разрабатывающей не только инновационные, но и безопасные ИИ-решения.

Ретроспектива: от калибровки до адаптации

За последние пять лет область оценки уверенности ИИ прошла значительный путь.

В 2021–2022 годах активно развивалась идея калибровочных слоёв, позволяющих нейросетям более точно предсказывать вероятности.

В 2022–2023 годах внимание было уделено байесовским нейросетям, способным оценивать разные типы неопределённости – эпистемическую и алеаторную.

В 2023 году в медицине начали применять ансамблевые модели для оценки неопределённости, например, в анализе изображений сетчатки (проект CAMEL на конференции WACV 2025).

В 2024 году популярность набрали Deep Ensembles – мощный инструмент снижения неопределённости.

А в 2025 году появилась технология адаптации ИИ на лету с учётом уровня уверенности («OT VP» также на WACV 2025).

Эти примеры показывают, что оценка доверия к прогнозам ИИ становится ключевым элементом надёжности систем. Российский метод Confidence Aware Training Data органично вписывается в этот тренд и может стать следующим этапом в развитии технологии.

Интерес к оценке будет расти

В ближайшие годы развитие пойдёт по нескольким направлениям. В академической среде будет расти интерес к мягким методам разметки, объединению подходов оценки уверенности и адаптации на лету.

В индустрии ожидается появление пилотных проектов в медицине, автомобилестроении и промышленной безопасности. Со стороны регуляторов, возможно, появятся новые стандарты, требующие обязательной оценки уверенности ИИ. А на международном рынке российские стартапы начнут предлагать модули с динамическим уровнем доверия.

Метод, разработанный учёными Сколтеха и ИППИ РАН, — это не просто научный прорыв, а важный шаг к более безопасному и ответственному искусственному интеллекту. Он вписывается в мировую тенденцию к созданию «честного» ИИ и имеет реальные перспективы на коммерческое внедрение.